视觉问答

视觉问答(Visual question answering,VQA)是一种结合计算机视觉和自然语言处理的新问题。通常涉及到给计算机展示一张图片,让计算机回答关于图片的问题。答案可以是以下任何一种形式:一个单词,一个词组,是/否,选择题答案,或者是填空题答案。

诸如 DAQUAR, Visual7W, COCO-QA, VQA 之类的多种数据集都致力于解决这项任务. 让我们同样来看看视觉问答领域的今年最佳:

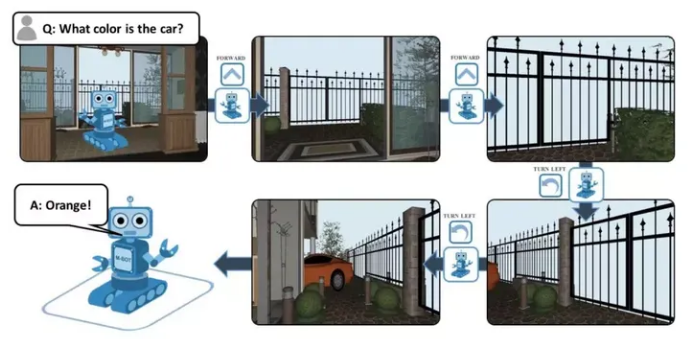

Embodied QA 以创建完全智能代理为目标,这些代理可以主动感知,在基于环境的对话中自然交流、表现和执行命令。通过目标驱动的 3D 设置智能导航,代理被要求基于对象识别和视觉定位和理解来回答问题。 有趣的是,该代理仅使用自我中心视觉来导航其周围环境。这意味着代理没有提供地图,只能通过原始感官输入(像素和单词)进行训练,并且必须依靠常识来导航不熟悉的环境。

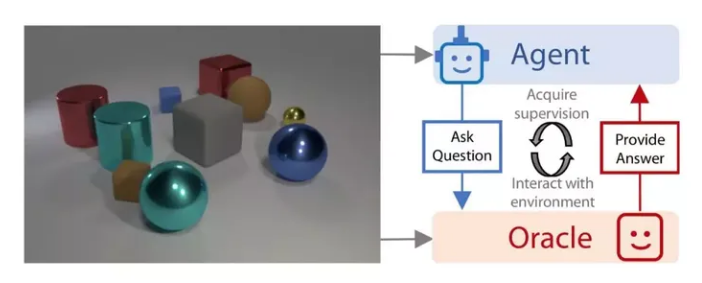

标准的 VAQ 模型不如人类自然互动那样采样高效、简要,而是被动地依赖于大型静态数据集。Learning by asking questions 通过引入模仿自然学习的更具互动性的 VQA 模型填补了这一研究空白。 在这篇文章中,通过评估其先前获得的知识并询问相关的好问题来最大化来自发送到 oracle 的每个图像-问题对学习信号,训练代理像人一样学习。 该论文还展示了交互式提问如何显著减少冗余和训练所需样本,以实现准确率提高40%。

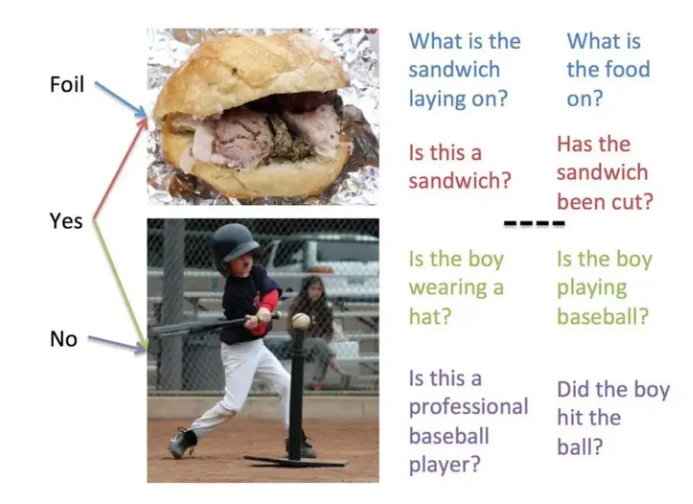

Inverse Visual QA (iVQA) 连接了其他旨在通过专注于开发视觉定位来提高标准 VQA 模型性能的模型。本文颠倒了流行的 VQA 任务,目标是在给定图像/答案对的情况下生成问题。标准 VQA 的学习偏差破坏了评估过程。iVQA 使用部分生成的问题,对应于图像-答案对的偏差较小的学习先验,以实现更多的视觉定位。

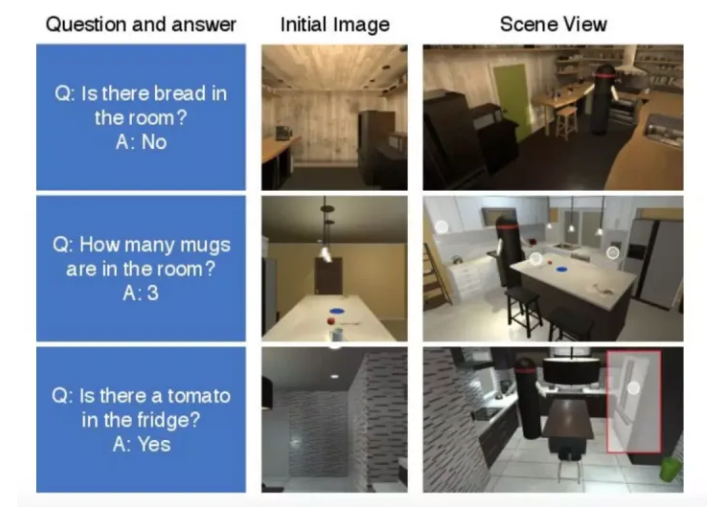

Interactive QA 致力于解决标准 VAQ 模型的一个短板:通常是被动的,不能训练能够在其环境中导航、交互和执行任务的完全智能的代理。该模型使用具有语义空间记忆的多级控制器方法,收集模拟真实场景的丰富数据集和广泛的问题以评估模型。它推动标准 VQA 朝着创建完全视觉智能代理的最终目标迈进。

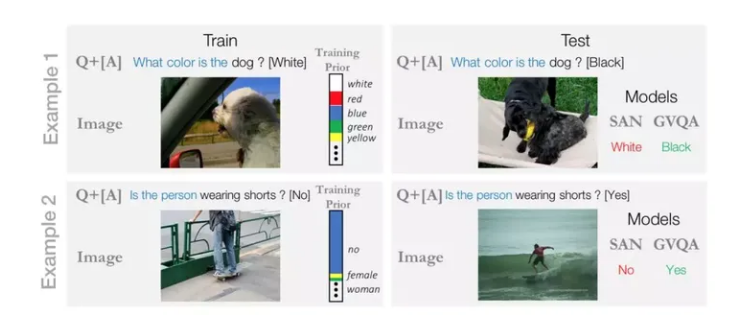

有效地评估当前最先进的 VQA 模型的性能并防止它们依赖有偏差的训练先验是一个仍在开发中的领域。为了这一目标,Grounded Visual QA 模型提供了一种新方法,可以直接分离从合理的先前答案中识别出的对象,从而迫使模型更多地去视觉定位。从该报告的优异成果以及当前社区对这一研究领域的关注来看,未来用创新方法进一步推进 VQA 模型很有希望。

版权所有:江苏和讯自动化设备有限公司所有 备案号:苏ICP备2022010314号-1

技术支持: 易动力网络