在当今的人工智能时代,神经网络以其卓越的对数据的拟合能力而备受瞩目。从图像识别到自然语言处理,从金融预测到医疗诊断,神经网络在各个领域都展现出了惊人的表现。那么,为什么神经网络对数据的拟合能力如此之强呢?

一、神经网络的基本结构

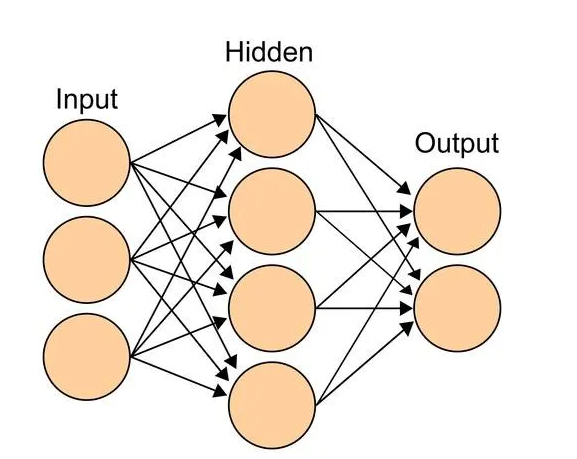

神经网络是一种模仿生物神经系统的计算模型,由大量的神经元相互连接而成。每个神经元接收来自其他神经元的输入信号,通过一定的计算规则进行处理,然后输出信号给其他神经元。神经网络通常由输入层、隐藏层和输出层组成。输入层接收外部数据,隐藏层对数据进行处理和转换,输出层则输出最终的结果。

神经元的计算规则通常是一个非线性函数,如 sigmoid 函数、ReLU 函数等。这种非线性函数使得神经网络能够学习到复杂的数据模式和关系。此外,神经网络还可以通过调整神经元之间的连接权重来优化模型的性能。

二、强大的表达能力

1.多层结构

神经网络的多层结构赋予了它强大的表达能力。通过多个隐藏层的堆叠,神经网络可以学习到不同层次的特征表示。低层次的隐藏层可以学习到数据的局部特征,如边缘、纹理等;高层次的隐藏层则可以学习到数据的全局特征,如物体的形状、类别等。这种层次化的特征表示使得神经网络能够对复杂的数据进行有效的拟合。

例如,在图像识别任务中,神经网络的第一层隐藏层可能学习到图像的边缘和纹理特征,第二层隐藏层可能学习到物体的轮廓特征,第三层隐藏层可能学习到物体的类别特征。通过这种层次化的学习,神经网络可以逐渐从原始图像中提取出有用的信息,从而实现准确的图像识别。

2.非线性激活函数

神经网络中的非线性激活函数也是其强大表达能力的重要来源。如果没有非线性激活函数,神经网络就退化为一个线性模型,只能学习到线性的数据模式。而现实中的数据往往是非线性的,因此非线性激活函数使得神经网络能够学习到复杂的非线性关系。

常见的非线性激活函数有 sigmoid 函数、tanh 函数、ReLU 函数等。这些函数在不同的情况下具有不同的优缺点,例如 sigmoid 函数和 tanh 函数在处理小数据时效果较好,但在处理大数据时容易出现梯度消失的问题;ReLU 函数则在处理大数据时表现出色,但在输入为负数时会出现神经元死亡的问题。因此,在实际应用中,需要根据具体情况选择合适的非线性激活函数。

三、大规模数据和强大的计算能力

1.数据驱动的学习

神经网络是一种数据驱动的学习方法,它通过大量的数据来训练模型,从而学习到数据中的模式和规律。随着大数据时代的到来,我们可以获取到海量的训练数据,这为神经网络的发展提供了有力的支持。大量的训练数据可以让神经网络学习到更加丰富的特征表示,提高模型的泛化能力。此外,数据的多样性也可以让神经网络学习到不同情况下的数据模式,增强模型的鲁棒性。

2.强大的计算能力

神经网络的训练需要进行大量的计算,包括矩阵乘法、非线性激活函数的计算等。随着计算机技术的不断发展,我们现在拥有了强大的计算能力,如 GPU、TPU 等专用硬件加速器,可以大大提高神经网络的训练速度。

强大的计算能力使得我们可以在短时间内训练大规模的神经网络,从而提高模型的性能。此外,计算能力的提升也使得我们可以尝试更加复杂的神经网络结构和算法,进一步挖掘神经网络的潜力。

四、自适应学习和优化算法

1.反向传播算法

反向传播算法是神经网络训练中最常用的优化算法之一。它通过计算损失函数对网络参数的梯度,然后根据梯度下降的原则来更新网络参数,从而最小化损失函数。

反向传播算法的优点是计算效率高,可以有效地处理大规模的神经网络。此外,反向传播算法还可以与各种优化算法结合使用,如随机梯度下降、动量法、Adam 算法等,进一步提高网络的训练速度和性能。

2.自适应学习率

在神经网络的训练过程中,学习率是一个非常重要的参数。学习率过大容易导致模型振荡,难以收敛;学习率过小则会导致训练速度过慢。

为了解决这个问题,人们提出了自适应学习率的方法,如 Adagrad 算法、RMSprop 算法、Adam 算法等。这些算法可以根据训练过程中的情况自动调整学习率,使得模型在训练过程中能够更加稳定地收敛。此外,自适应学习率还可以提高模型的训练速度和性能,减少训练时间和资源消耗。

五、泛化能力和正则化技术

1.泛化能力

神经网络的泛化能力是指模型在未见过的数据上的表现能力。一个好的神经网络应该具有良好的泛化能力,能够对新的数据进行准确的预测。

为了提高神经网络的泛化能力,我们可以采用一些方法,如增加训练数据的数量和多样性、使用正则化技术、早停法等。这些方法可以防止模型过拟合,提高模型的泛化能力。

2.正则化技术

正则化技术是一种防止模型过拟合的方法。它通过在损失函数中加入正则项,来限制模型的复杂度,从而提高模型的泛化能力。

常见的正则化技术有 L1 正则化、L2 正则化、Dropout 等。L1 正则化和 L2 正则化通过对网络参数的大小进行限制,来防止模型过拟合;Dropout 则通过随机丢弃神经元的方式,来增加模型的鲁棒性和泛化能力。

六、应用领域的广泛成功

神经网络在各个领域的广泛成功也证明了它对数据的强大拟合能力。在图像识别领域,神经网络可以实现高精度的图像分类、目标检测和图像分割等任务;在自然语言处理领域,神经网络可以进行文本分类、机器翻译、情感分析等任务;在金融预测领域,神经网络可以对股票价格、汇率等进行预测;在医疗诊断领域,神经网络可以辅助医生进行疾病诊断和治疗决策等。

这些成功的应用案例表明,神经网络能够有效地学习到数据中的模式和规律,对复杂的数据进行准确的拟合和预测。

综上所述,神经网络对数据的拟合能力之所以如此之强,是由于其多层结构、非线性激活函数、大规模数据和强大的计算能力、自适应学习和优化算法、泛化能力和正则化技术等多方面的因素共同作用的结果。随着技术的不断发展,神经网络的性能还将不断提高,为我们解决更多的实际问题提供有力的支持。

版权所有:江苏和讯自动化设备有限公司所有 备案号:苏ICP备2022010314号-1

技术支持: 易动力网络